使用 Canonical 和 NVIDIA AI Enterprise 加快 AI 应用程序开发

by Canonical on 7 November 2023

NVIDIA AI Enterprise 支持 Ubuntu KVM

Canonical 将继续扩大与 NVIDIA 的合作范围,为将于今天全面上市的NVIDIA AI Enterprise 4.0 提供 Ubuntu KVM Hypervisor 支持。在 Ubuntu 上使用 GPU 虚拟化的企业组织有望无缝迁移到新版 NVIDIA AI Enterprise 许可证。

NVIDIA AI Enterprise 4.0

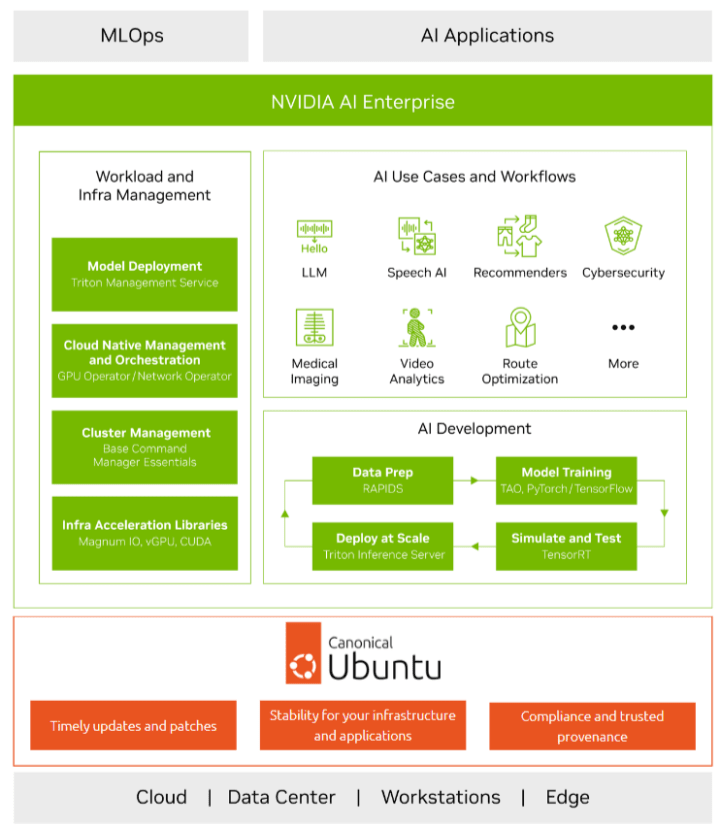

NVIDIA AI Enterprise 4.0 现在具有跨工作站、数据中心和云部署支持功能,且更新中包括:

- NVIDIA NeMo,用于构建、定制和部署生成式人工智能模型;

- 两个新的人工智能工作流,用于加速生成式人工智能用例;

- 通过 NVIDIA Triton 管理服务增强可管理性,实现大规模自动化部署;

- 企业级支持。

NVIDIA AI Enterprise 为人工智能应用程序开发和部署提供了一个端到端且安全的云原生软件平台,帮助企业组织解决新挑战,同时提高运营效率。新的 NVIDIA Triton 管理服务可以简化并有效管理模型部署,并且 NeMo 支持构建、定制和部署复杂的大型语言模型,为企业提供一种简单、经济、快速的方式来使用生成式人工智能。

Ubuntu KVM 和 NVIDIA Enterprise 4.0

普遍将 NVIDIA 框架和工作流与 Ubuntu 结合使用的数据科学家和开发人员现拥有一个单一的平台,可以在最新一代 NVIDIA GPU 的基础之上快速开发人工智能应用程序。随着 Ubuntu KVM 支持 GPU 虚拟化,企业组织可以利用现有的本地或云基础架构快速部署相同的模型来支持 AI 工作负载的运行。

GPU 虚拟化是一个重要的工具,可以在多个虚拟机(VM)间共享单个 GPU。这样可以优化 GPU 资源利用率,并且直接为受宏观影响的 IT 预算节省大量成本。Ubuntu KVM 历来一直支持 NVIDIA 虚拟 GPU(vGPU)解决方案。Canonical 和 NVIDIA 现已验证 NVIDIA 的虚拟化解决方案,使 NVIDIA AI Enterprise 容器和虚拟机均支持 GPU,并将性能影响降到最低。一旦客户和用户指向新的 NVIDIA AI Enterprise 许可证服务器,则应在不中断的情况下继续使用。

企业将 NVIDIA AI Enterprise 与 Ubuntu KVM 结合使用,现可跨多云和混合云部署来扩展部署。

安全性和支持 —— 确保完整的深度学习堆栈

Ubuntu 是大多数人工智能开发人员的首选开源操作系统,Canonical 很自豪能够通过提供优化的、安全的操作系统,为 NVIDIA 的创新者提供支持。NVIDIA 客户使用 NVIDIA AI Enterprise 4.0,可以自动享有 Canonical 在操作系统之外的安全承诺,从而确保 NVIDIA 容器中开源内容的安全。旨在部署最新人工智能创新技术的企业组织使用 NVIDIA AI Enterprise,现在可以获得 NVIDIA 提供的企业级支持。此外,客户还可以获得 Canonical 针对其开源基础架构软件提供的支持,包括 Kubernetes 和 Kubeflow 等热门上游项目。

在谈及这些解决方案时,Canonical AI/ML 负责人 Maciej Mazur 表示:“经认证,Ubuntu KVM 与 NVIDIA AI Enterprise 相结合可以为客户提供端到端解决方案的所有必要要素:NVIDIA 提供的用于培训最新 LLM 的容器,以及 Canonical 提供的针对基础架构软件的企业级支持。”

入门简单且免费。您可以放心,如有需要,Canonical 专家可以提供帮助。

NVIDIA AI Enterprise 与 Canonical 开源解决方案结合使用入门

- 查看更多关于 Canonical 和 NVIDIA 致力于帮助企业运用人工智能的信息

- 观看我们携手 NVIDIA 和 Dell 推出的关于生成式人工智能的联合网络研讨会

- 观看 Charmed Openstack 结合 NVIDIA vGPU 技术的网络研讨会

- 在 Ubuntu KVM 上试用 NVIDIA AI Enterprise,并提供 90 天免费评估

订阅博客文章

查看更多内容

Ubuntu 正式支持 NVIDIA Jetson

Ubuntu 正式支持 NVIDIA Jetson:助力边缘 AI 未来发展 Canonical 宣布推出支持 NVIDIA® Jetson Orin™ 的 Ubuntu 正式发布版本,该版本专为边缘 AI 和机器人领域打造,为全球 AI 开发者带来优化的性能、开箱即用的兼容性以及实现高性能 AI 解决方案的便捷途径。 Ubuntu 发行商 Canonical 宣布正式支持 NVIDIA Jetson 平台,标志着其与 NVIDIA 的合作迎来重要里程碑,为加速边缘 AI 领域创新再添动力。此次正式发布(GA)版本为 Ubuntu 与 NVIDIA Jetson 系统级模块解决方案的强大组合赋予了企业级的稳定性与技术支持。 为各行各业 AI 创新赋能 此次通过 Canon […]

利用开源机器学习基础架构加速 AI 发展

人工智能技术在迅速发展,对稳健强大且可扩展的基础架构具有迫切需求。为应对这些挑战,我们精心打造了一套全面的参考架构(RA),充分利用了开源工具与尖端硬件的强大功能与性能。这套架构基于 Canonical 的 MicroK8s 和 Charmed Kubeflow 构建,运行于 Dell PowerEdge R7525 服务器之上,并借助NVIDIA NIM 微服务实现加速,为部署和管理机器学习工作负载提供了一个简便高效的途径。 为数据科学家与工程师赋能 该解决方案旨在为数据科学家和机器学习工程师赋能,使其能够实现更快迭代、无缝扩展以及强有力的安全保障。对于基础架构构建者、解决方案架构师、DevOps 工程师以及首席技术官(CTO)而言,这套参考架构提供了一条畅通无阻的途径 […]

Canonical 和 Renesas 宣布将合作加速企业 AI 创新

Ubuntu 的发行商 Canonical 宣布,半导体解决方案的全球领导者 Renesas Electronics Corporation 已加入 Canonical 的硅合作伙伴计划,以提供量身定制的尖端解决方案来满足边缘计算和 AI 应用不断增长的需求。随着行业越来越多地采用 AI 驱动的解决方案,对高效、可扩展和安全维护的边缘计算平台的需求前所未有地高涨。此次合作将结合 Renesas 在嵌入式处理方面的专业知识和 Canonical 全面的物联网(IoT)软件堆栈。 可扩展的生产级解决方案 Canonical 和 Renesas 的合作旨在为原始设备制造商(OEM)和原始设计制造商 (ODM)提供可扩展的生产级解决方案,从而缩短上市时间(TTM)。Renesas […]